Was machen Experimentalphysiker am CERN? Weißrussisch über die Arbeit am Large Hadron Collider

[[K:Wikipedia:Artikel ohne Quellen (Land: Lua-Fehler: callParserFunction: Funktion „#property“ wurde nicht gefunden. )]][[K:Wikipedia:Artikel ohne Quellen (Land: Lua-Fehler: callParserFunction: Funktion „#property“ wurde nicht gefunden. )]]

Experimentelle Physik- eine Art der Naturerkenntnis, die darin besteht, Naturphänomene unter speziell vorbereiteten Bedingungen zu studieren. Im Gegensatz zur theoretischen Physik, die mathematische Modelle der Natur untersucht, ist die Experimentalphysik darauf ausgelegt, die Natur selbst zu untersuchen.

Die Uneinigkeit mit dem Ergebnis des Experiments ist das Kriterium für den Irrtum einer physikalischen Theorie, oder genauer gesagt, für die Unanwendbarkeit der Theorie auf unsere Welt. Die umgekehrte Aussage trifft nicht zu: Die Übereinstimmung mit dem Experiment kann kein Beweis für die Richtigkeit (Anwendbarkeit) der Theorie sein. Das heißt, das Hauptkriterium für die Durchführbarkeit einer physikalischen Theorie ist die experimentelle Überprüfung.

Diese mittlerweile offensichtliche Rolle des Experiments wurde erst Galileo und späteren Forschern bewusst, die auf der Grundlage von Beobachtungen des Verhaltens von Objekten unter besonderen Bedingungen Rückschlüsse auf die Eigenschaften der Welt zogen, d. h. sie führten Experimente durch. Beachten Sie, dass dies beispielsweise völlig im Gegensatz zum Ansatz der alten Griechen steht: Nur die Reflexion schien ihnen die Quelle wahren Wissens über die Struktur der Welt zu sein, und „Sinneserfahrung“ galt als Gegenstand zahlreicher Täuschungen und Unsicherheiten und konnte daher keinen Anspruch auf wahres Wissen erheben.

Idealerweise sollte die Experimentalphysik nur liefern Beschreibung Ergebnisse des Experiments, ohne welche Interpretationen. In der Praxis ist dies jedoch nicht erreichbar. Die Interpretation der Ergebnisse eines mehr oder weniger komplexen Experiments hängt zwangsläufig davon ab, dass wir verstehen, wie sich alle Elemente des Versuchsaufbaus verhalten. Ein solches Verständnis wiederum kann sich nur auf einige Theorien stützen. Experimente in der Beschleunigerphysik von Elementarteilchen – eines der komplexesten in der gesamten Experimentalphysik – können daher erst dann als echte Untersuchung der Eigenschaften von Elementarteilchen interpretiert werden, wenn die mechanischen und elastischen Eigenschaften aller Detektorelemente und ihre Reaktion auf elektrische und elektrische Einflüsse untersucht werden Magnetfelder, Eigenschaften von Restgasen in einer Vakuumkammer, Verteilung des elektrischen Feldes und Drift von Ionen in Proportionalkammern, Prozesse der Ionisierung von Materie usw.1

Schreiben Sie eine Rezension zum Artikel „Experimentalphysik“

Ein Auszug, der die Experimentalphysik charakterisiert

Damals wusste ich noch nichts über den klinischen Tod oder die leuchtenden Tunnel, die dabei entstanden. Aber was dann geschah, war all den Geschichten über klinische Todesfälle sehr ähnlich, die ich viel später, als ich bereits im fernen Amerika lebte, in verschiedenen Büchern lesen konnte ...Ich hatte das Gefühl, wenn ich jetzt keine Luft mehr atmen würde, würden meine Lungen einfach platzen und ich würde wahrscheinlich sterben. Es wurde sehr beängstigend, meine Sicht wurde dunkel. Plötzlich blitzte ein heller Blitz in meinem Kopf auf und alle meine Gefühle verschwanden irgendwo ... Ein blendend heller, durchsichtiger blauer Tunnel erschien, als wäre er vollständig aus winzigen, sich bewegenden silbernen Sternen gewoben. Ich schwebte ruhig in ihm, spürte weder Erstickung noch Schmerz, sondern war nur geistig erstaunt über das außergewöhnliche Gefühl absoluten Glücks, als hätte ich endlich den Ort meines lang ersehnten Traums gefunden. Es war sehr ruhig und gut. Alle Geräusche verschwanden, ich wollte mich nicht bewegen. Der Körper wurde sehr leicht, fast schwerelos. Höchstwahrscheinlich war ich in diesem Moment einfach am Sterben ...

Ich sah einige sehr schöne, leuchtende, durchsichtige menschliche Gestalten, die langsam und sanft durch den Tunnel auf mich zukamen. Sie lächelten alle herzlich, als würden sie mich zu sich rufen... Ich streckte schon die Hand nach ihnen aus... als plötzlich von irgendwoher eine riesige leuchtende Palme auftauchte, mich von unten packte und wie ein Sandkorn begann um mich schnell an die Oberfläche zu heben. Mein Gehirn explodierte unter dem Ansturm scharfer Geräusche, als wäre plötzlich eine schützende Trennwand in meinem Kopf geplatzt ... Ich wurde wie ein Ball an die Oberfläche geschleudert ... und war taub von einem wahren Wasserfall aus Farben, Geräuschen und Empfindungen. die aus irgendeinem Grund von mir jetzt viel heller wahrgenommen wurden als gewöhnlich.

Am Ufer herrschte echte Panik ... Die Nachbarsjungen riefen etwas, wedelten ausdrucksvoll mit den Armen und zeigten in meine Richtung. Jemand hat versucht, mich an Land zu ziehen. Und dann schwebte alles, wirbelte in einer Art verrücktem Strudel, und mein armes, überanstrengtes Bewusstsein verschwand in völliger Stille... Als ich allmählich „zur Besinnung kam“, standen die Jungs mit vor Entsetzen großen Augen um mich herum und alle zusammen ähnelten irgendwie identischen verängstigten Eulen... Es war klar, dass sie sich die ganze Zeit über in einem echten Panikschock befanden und mich anscheinend bereits geistig „begraben“ hatten. Ich versuchte ein Lächeln vorzutäuschen und erstickte immer noch an der Wärme Flusswasser, brachte mit Mühe heraus, dass bei mir alles in Ordnung sei, obwohl ich in diesem Moment natürlich überhaupt nicht in Ordnung war.

Zu viele Bücher? Sie können Bücher auf Anfrage „Experimentelle Physik“ klären (die Anzahl der Bücher für diese Klarstellung ist in Klammern angegeben)

Anzeigestil wechseln:

Molekulare Theorie der Adsorption in porösen Körpern

Abwesend

Prozesse in porösen Körpern bilden die Grundlage vieler traditioneller und moderne Technologien: Katalytisch, Sorption, Membran, elektrochemisch, chromatographisch, Reinigung und Trennung von Flüssigkeits- und Gasgemischen, Kapillarkondensation und -desorption, Mehrphasenfiltration und -zerstäubung, Benetzung...

Abwesend

Die Monographie präsentiert verallgemeinerte Ergebnisse theoretischer und experimenteller Studien zur Wechselwirkung von Laserstrahlung mit Metallen beim Laserschneiden von Blechmaterialien. Besonderes Augenmerk liegt auf der Konstruktion physikalischer und mathematischer Modelle unter Berücksichtigung der Vielfalt thermophysikalischer Prozesse, der Haupt- und...

Abwesend

Es werden theoretische und angewandte Fragestellungen der Flugzeugaerodynamik vorgestellt. Es werden Informationen aus der Kinematik und Dynamik von Gasen präsentiert; Es werden die Grundgleichungen der Aerodynamik, analytische und numerische Methoden zur Berechnung von Wirbel-, Potential-, ebenen, räumlichen und viskosen Strömungen angegeben. Theorien mit...

Abwesend

Das Buch enthält Aufgaben und mögliche Lösungen für die II. Internationale Olympiade in Experimentalphysik, die vom 27. November bis 7. Dezember 2014 im Kindergesundheits- und Bildungszentrum „Team“ stattfand. Die Olympiade wurde für Schüler der Klassen 8–11 ausgetragen und umfasste jeweils drei Runden…

Abwesend

Die Monographie widmet sich einer systematischen Darstellung der Grundlagen der Physik fluktuierender elektromagnetischer Felder von Festkörpern und deren Zusammenhang mit grundlegenden Phänomenen in der Natur. Moderne theoretische Modelle thermischer Felder und verschiedene Methoden zur Beschreibung ihrer Korrelationseigenschaften werden aus einer einheitlichen Position präsentiert. N...

Abwesend

Das Buch widmet sich dem Problem der Phasenumwandlungen in Festkörpern bei hohem Druck (HP). Folgende Themen werden berücksichtigt: Phasengleichgewichte bei hohem Druck in Elementen (Kohlenstoff, Silizium, Germanium, Titan, Zirkonium, Eisen, Gallium, Cer), in Verbindungen I VII II VI III V Typ A B; A B ; A B, in Legierungen auf Basis von…

Abwesend

Die Monographie untersucht symmetrische und asymmetrische getrennte Strömungen und ihre Umstrukturierung um Körperpaare unterschiedlicher Form in einem weiten Bereich von Mach- und Reynolds-Zahlen. Es werden instationäre, getrennte Strömungen um verschiedene Körper (Kugel, Ende, Kegel) analysiert, vor denen ein nicht rotierender oder rotierender…

Abwesend

Die Monographie präsentiert die Ergebnisse experimenteller Studien zur Erzeugung gepulster Elektronen- und Ionenstrahlen mit Gigawattleistung in Dioden mit einer explosiven Emissionskathode unter Bedingungen einer schnellen Plasmabildung auf der gesamten Arbeitsfläche der Kathode. Die wichtigsten werden berücksichtigt physikalische Prozesse usw…

Abwesend

Es werden die Hauptmerkmale der gestreuten und intrinsischen radiothermischen Strahlung natürlicher Umgebungen betrachtet. Es wird eine Analyse elektrodynamischer Modelle verschiedener Erdoberflächen und der umgebenden Atmosphäre gegeben. Modelle von Funksignalen und deren statistischen Eigenschaften im Bereich der Funkaufzeichnung wurden entwickelt...

Das Buch enthält Beschreibungen pädagogischer experimenteller Studien zum Phänomen der Totalreflexion an der Grenze optisch homogener und geschichteter inhomogener Medien. Es werden einfache physikalische Geräte und Modelle vorgeschlagen. Es werden unterhaltsame und lehrreiche Experimente berücksichtigt. Alle Experimente sind verfügbar und können…

Abwesend

Die Arbeit fasst die Ergebnisse von Untersuchungen zum Elektretzustand anorganischer und organischer Oxidverbindungen zusammen und untersucht den Einfluss des Elektretzustands auf die Entwicklung der ferroelektrischen Polarisation und die elektrischen Eigenschaften von Ferroelektrika. Fragen des praktischen Nutzens…

Abwesend

Es werden die wichtigsten Methoden zur Berechnung der Verteilung der molekularen Flussdichte über die Oberflächen von Vakuumanlagen vorgestellt. Die wichtigsten Methoden zur Modellierung von Vakuumbedingungen mit einer gegebenen Dichte molekularer Flüsse wurden untersucht. Anhand von Beispielen betrachten wir die Berechnung der Verteilung der molekularen Flussdichte über...

Abwesend

Das Buch fasst die Ergebnisse einer theoretischen Untersuchung des Prozesses der Elektronenbeschleunigung in klassischen kreisförmigen und geschnittenen Mikrotrons, die Ergebnisse von Experimenten zur Überprüfung theoretischer Schlussfolgerungen und zur Untersuchung der Eigenschaften von in einem Mikrotron beschleunigten Elektronen zusammen. Möglichkeiten zur Verwendung von Mikrotrons werden in Betracht gezogen...

Abwesend

Es werden Ergebnisse experimenteller und theoretischer Untersuchungen gasdynamischer Prozesse in Kanälen vorgestellt. Die Untersuchung getrennter Strömungsprozesse ermöglichte es, die Hauptmuster zu identifizieren, Ähnlichkeitsparameter zu bestimmen und auf dieser Grundlage ungefähre theoretische Modelle dieser komplexesten...

Abwesend

Das Handbuch behandelt Fragen im Zusammenhang mit den Grundlagen der Quantentheorie, spezifischen Merkmalen von Quantenobjekten und Präzisionsmessungen bei Interferenz dritter Ordnung und Selbstwirkung von Licht in Medien mit kubischer Nichtlinearität. Parametrische Lichtstreuung in Quanten- und...

Abwesend

Es werden die Grundlagen der Kompressibilitätstheorie kondensierter Materie, der Aufbau und die Eigenschaften von Spreng- und Stoßbelastungstechniken sowie die Funktionsprinzipien von Mess- und Aufzeichnungsgeräten für gasdynamische Experimente mit kondensierter Materie erläutert. Algorithmen zur Merkmalsfindung...

Abwesend

Es werden verschiedene Klassen inverser Probleme der Mechanik eines verformbaren Festkörpers betrachtet – Retrospektiv-, Rand-, Koeffizienten- und geometrische Probleme, bei denen unter Verwendung einiger zusätzlicher experimenteller Informationen über die Lösung die Koeffizienten von Differentialoperatoren, Anfangsbedingungen, Gran...

Abwesend

Die Monographie fasst die Forschungsergebnisse des Autors auf dem Gebiet der Aerodynamik von Propellern und Propellerringen zusammen. Berücksichtigt werden die Eigenschaften von ein-, koaxialen, zweireihigen Propellern mit unterschiedlicher Blattzahl im Profilring und ohne Ring. Die Eigenschaften der Luft...

Abwesend

Berücksichtigt werden physikalische, mathematische und numerische Modelle der Wechselwirkung von kollisions- und kollisionsfreien Plasmaströmen mit in sie eingebrachten Körpern. Es wurden umfangreiche Computerexperimente durchgeführt, in deren Ergebnis die Verteilungsfunktionen geladener Teilchen im Frontal-, Lateral- und…

Abwesend

Das Hauptmerkmal des Lehrbuchs ist ein mehrstufiges Konzept zur Darstellung der wichtigsten experimentellen Fakten und der Grundlagen der Theorie physikalischer Phänomene unter Berücksichtigung moderner wissenschaftlicher Errungenschaften. Das Buch umfasst die folgenden Hauptabschnitte: elektromagnetische Theorie des Lichts, Lichtemission, Interferenz, Beugung, Streuung …

Abwesend

Das Buch ist Band II der Monographie „Aerogasdynamik von Strahldüsen“. Es widmet sich der Lösung eines so wichtigen Problems wie der Steuerung getrennter Strömungen in Domänenbereichen, um den Bodenwiderstand zu verringern. Es wurde eine Verallgemeinerung einer großen Menge hauptsächlich experimenteller Daten vorgenommen, p...

Abwesend

Diese Monographie widmet sich der Theorie optischer Mikrokavitäten mit hohem Q und ihrer Anwendung in der linearen, nichtlinearen, Quanten- und angewandten Optik. Optische Mikrokavitäten mit Flüstergalerie-Modi, die von russischen Wissenschaftlern entwickelt wurden, kombinieren auf einzigartige Weise Submillimetergröße mit ...

Abwesend

Behandelt werden die Themen Wärme- und Stoffübergang beim Züchten von Einkristallen aus einer Schmelze. Berücksichtigt werden physikalische und mathematische Modelle von Wärmeübertragungs- und Bildungsprozessen beim Wachstum von Kristallen aus einer Schmelze. Das Hauptaugenmerk liegt auf der experimentellen und theoretischen Untersuchung von Wärmeprozessen…

Abwesend

Die Monographie diskutiert methodische Grundlagen Schaffung komplexer technischer Systeme, die gegen destabilisierende Faktoren verschiedener physikalischer Natur resistent sind. Am Beispiel von Flugzeugen wird die Vorgehensweise zur rechnerischen und experimentellen Bewertung der Betriebsfestigkeit betrachtet. Es wird gezeigt, wie auf Basis der entwickelten...

Abwesend

Die Monographie widmet sich einer Vielzahl physikalischer Phänomene und Eigenschaften komprimierter und erhitzter Materie bei hohen Energiedichten. Berücksichtigt werden Methoden der Erzeugung, Diagnostik sowie theoretische Methoden zur Beschreibung des Verhaltens von Materie bei extrem hohen Drücken und Temperaturen, die in Laboratorien gewonnen werden...

Die vorliegende Monographie widmet sich dem Problem modellhafter und großmaßstäblicher experimenteller dynamischer Studien von Gebäudestrukturen von Kernkraftwerken. Der Zweck dieser Forschung bestand darin, dynamische Phänomene in den Gebäudestrukturen von Kernkraftwerken zu untersuchen, die mit vom Menschen verursachten Vibrationen verschiedener Art verbunden sind.

Abwesend

Die Ergebnisse überwiegend experimenteller Untersuchungen zu den Prozessen Verbrennung, Zündung/Selbstzündung, schnelle Deflagration und Detonation in wasserstoffhaltigen Brennsystemen werden zusammengefasst. Für die Analyse wurden Studien unter Ausgangsbedingungen ausgewählt, die für Wasserprobleme von praktischem Interesse sind...

Abwesend

Die Monographie fasst die Ergebnisse theoretischer und experimenteller Forschung auf dem Gebiet der Physik des Kontaktschmelzens fester Lösungen mit Metallen und der elektrischen Übertragung in Kontaktschichten zusammen. Der Mechanismus der Anfangsphase des Kontaktschmelzens auf Nanoebene wird betrachtet. Der Einfluss kleiner Verunreinigungen wird beschrieben...

Abwesend

Die Monographie enthält Beschreibungen von Patenten der Russischen Föderation für Erfindungen auf dem Gebiet der Detektormaterialien und -geräte, die in den letzten 10 Jahren der Entwicklung erzielt wurden und in der Abteilung für Experimentalphysik (EP) der USTU-UPI in Zusammenarbeit mit anderen Abteilungen und durchgeführt wurden Organisationen, auch ausländische. In Ehren...

Abwesend

Das Buch bespricht die Entwicklung von Methoden zur Reproduktion der Bedingungen des Orbitalflugs in Laborexperimenten auf der Grundlage der Geschwindigkeit der auf das Flugzeug einfallenden Ströme geladener und neutraler Teilchen, ihrer Konzentration und Temperatur sowie die Untersuchung der Eigenschaften von Geräten in solchen Strömen. Zum Beispiel...

Abwesend

Das Tutorial ist eine Anleitung zur Durchführung des notwendigen physikalischen Experiments und zur Verarbeitung von Messergebnissen. Enthält Beschreibungen von Laborarbeiten in den Abschnitten „Translationsbewegung“, „Rotationsbewegung“, „Mechanische Schwingungen“ und „Elastische Kräfte“. Diese Veröffentlichung ist…

Abwesend

Das Buch widmet sich der Darstellung langjähriger Erfahrungen in der Entwicklung, Erstellung und Nutzung kurzfristiger gasdynamischer Anlagen für aerodynamische Experimente. Gegeben detaillierte Beschreibung Vom Autor entwickelte Entwürfe gasdynamischer Anlagen für experimentelle Studien in ...

Abwesend

Berücksichtigt werden die einfachsten angewandten Versionen der Theorie der elastoplastischen Verformung unter proportionaler (einfacher) und disproportionaler (komplexer) Belastung. Methoden zur Identifizierung materieller Funktionen, die Varianten der Theorie nahe kommen, werden skizziert. Theoretische und experimentelle Ergebnisse werden analysiert...

Abwesend

Das Buch ist eine Einführung in die moderne Optik von Gaußschen Strahlen und befasst sich mit einer Vielzahl von Fragen im Zusammenhang mit der Bildung und Transformation paraxialer Lichtfelder und verallgemeinert die klassischen Hermite-Gaußschen und Laguerre-Gaußschen Strahlen. Die Theorie strukturell stabiler Lichtfelder wurde erstmals vorgestellt, in...

Abwesend

Die Monographie fasst und systematisiert die Ergebnisse von Studien zu Strahlsystemen zur Erhöhung des Auftriebs von Flügeln, die am TsAGI durchgeführt und in den letzten 30–40 Jahren in in- und ausländischen Publikationen veröffentlicht wurden. Grenzschicht- und Zirkulationskontrollsysteme durch ...

Abwesend

Das auf experimentellen Daten basierende Buch beschreibt eine Methode zur Untersuchung geschichteter Nanostrukturen basierend auf der Verwendung von Spiegelreflexion, Transmission, Brechung und Streuung polarisierter Neutronen. Anhand konkreter Beispiele werden die Elemente der Theorie des Neutronendurchgangs durch eine Schichtstruktur vorgestellt...

Abwesend

Das Buch untersucht Fragen des Wärmeaustauschs in Systemen, in denen aus verschiedenen Gründen Wärme freigesetzt wird (elektrische Maschinen und Geräte, Beschleuniger geladener Teilchen). Die Untersuchung von Wärmeübertragungsprozessen erfolgt auf Basis der erhaltenen exakten und näherungsweisen analytischen Lösungen. In oh...

Abwesend

Die Monographie widmet sich der Beschreibung der physikalischen Eigenschaften der Oberfläche, modernen experimentellen Methoden zu ihrer Untersuchung und theoretischen Methoden zur Berechnung der Oberflächen- und Haftungseigenschaften verschiedener Materialien. Es werden von den Autoren entwickelte Methoden vorgestellt, die in guter Übereinstimmung mit experimentellen…

Abwesend

Basierend auf den Grundprinzipien der Elektrodynamik wurde eine in sich konsistente Theorie der Anregung und Kopplung von Wellenleitermoden entwickelt, die auf alle (geschlossenen und offenen) Wellenleiterstrukturen anwendbar ist. Wellenleiterstrukturen, die Medien mit isotropen, anisotropen und bianisotropen Eigenschaften enthalten...

Abwesend

Vorgeführt moderne Techniken Es werden experimentelle Messungen, Daten zu den Grundlagen der Erstellung mathematischer Modelle vorgestellt, die den Zustand einer brennenden Gassuspension für verschiedene Anfangseigenschaften von Turbulenzen, Gassuspensionszusammensetzungen und Betriebsparameter beschreiben. Die Ergebnisse der Experimente werden berücksichtigt...

Abwesend

Der Artikel untersucht die Probleme der Diagnose von Inhomogenitäten in der aquatischen Umwelt mithilfe einer hydroakustischen parametrischen Antenne. In diesem Fall haben die Heterogenitäten der aquatischen Umwelt eine geometrisch regelmäßige Form: Kugeln, Zylinder und Sphäroide. Wellenprozesse werden theoretisch und experimentell untersucht, pro...

Abwesend

Die Monographie untersucht eine Reihe von Fragen im Zusammenhang mit den Problemen der Beschreibung und experimentellen Zertifizierung einzelner Grenzen und Ensembles von Korngrenzen in Polykristallen sowie Untersuchungen ihrer Rolle bei Prozessen wie Korngrenzendiffusion, -relaxation und Kornwachstum. Es wurde versucht, eine ausreichende...

Abwesend

Das Lehrbuch ist der erste Teil der Reihe „Universitätslehrgang Allgemeine Physik“, die sich an Studierende physikalischer Fachrichtungen an Universitäten richtet. Seine Besonderheit ist ein mehrstufiges Konzept zur Darstellung der wichtigsten experimentellen Fakten und Grundlagen der Theorie physikalischer Phänomene unter Berücksichtigung moderner...

Abwesend

Die Monographie untersucht die Probleme der Verbrennung von Kraftstoffen in Wärmekraftmaschinen für verschiedene Zwecke sowie die Auswirkungen ihrer Verbrennungsprodukte auf Mensch und Umwelt. Es werden die Mechanismen der Bildung toxischer Stoffe bei der Verbrennung und Möglichkeiten zur Reduzierung ihrer Emissionen beschrieben. Es wird eine Methode zur Berechnung der Gleichgewichtszusammensetzung von Produkten beschrieben...

Abwesend

Das Buch beschreibt in Bezug auf elektrische Maschinen eines neuen Typs die Ergebnisse der Forschung zu den grundlegenden Eigenschaften, der Struktur und der Dynamik von Zwischen- und Mischzuständen von Niedertemperatur- und Hochtemperatur-Supraleitern vom Typ I und II. Lokale Änderung des Phasenzustands eines Supraleiters...

Abwesend

Das Lehrbuch ist in Übereinstimmung mit den Inhalten der staatlichen Bildungsstandards, des Workshop-Programms (Abschnitt „Biochemische Analysemethoden“), des Disziplinprogramms „Chemische Grundlagen und Methoden der Analyse lebender Systeme“, des Disziplinprogramms „Biotechnologie und Organisation von“ verfasst analytisch...

Abwesend

Die Ergebnisse der Systematisierung von Studien zur konvektiven Wärmeübertragung von Flugzeugen in der atmosphärischen Flugphase werden vorgestellt, einschließlich der Berücksichtigung des Einflusses dreidimensionaler Strömungen, physikalisch-chemischer Nichtgleichgewichtsprozesse im Gas und auf der Oberfläche des Fahrzeugs, laminar-turbulent Übergang der Grenze...

Abwesend

Das Buch präsentiert die Ergebnisse experimenteller Studien zu den Mechanismen des Auftretens instabiler Verbrennungsmodi in Modellbrennkammern. Die Mechanismen der Emission von Schallschwingungen durch eine modulierte Ladung, Fragen der Diagnose und Kontrolle der Verbrennungsinstabilität mithilfe elektrischer...

Abwesend

Dieses Buch widmet sich der Entdeckung und Untersuchung eines neuen Effekts – der induzierten Drift, die durch die Einwirkung periodischer elektrischer und magnetischer Felder auf strukturierte Salzlösungen in flüssigen polaren Dielektrika verursacht wird. Es enthält Informationen sowohl experimenteller als auch theoretischer Natur ...

Abwesend

Beschrieben werden die Möglichkeiten und der aktuelle Stand der Erforschung von Niedertemperaturplasma mittels klassischer und Laserspektroskopie-Methoden. Die Fragen der physikalischen Interpretation der Ergebnisse der Anwendung der Methoden der Emission, Absorption, Brechung und Streuung von Licht auf ein thermisch nicht im Gleichgewicht befindliches Plasma sowie ihre Zusammenhänge werden betrachtet...

Abwesend

Ausgewählte Vorträge des herausragenden amerikanischen Physikers und Preisträgers Nobelpreis R. Feynman. Sie untersuchen die Entwicklungsstadien der modernen Physik und ihrer Konzepte, die Verbindung der Physik mit anderen Wissenschaften, die Theorie der Schwerkraft, die Quantenmechanik, die Symmetrie der Gesetze der Physik, die spezielle Relativitätstheorie...

Abwesend

Das Buch widmet sich einer experimentellen Untersuchung des Zusammenhangs zwischen der quasigeordneten Struktur einer turbulenten Grenzschicht und den traditionell gemessenen gemittelten Eigenschaften der Strömung in der Grenzschicht. Der Mechanismus der periodischen Erneuerung der Strömung in der viskosen Unterschicht einer turbulenten Grenzschicht wird betrachtet...

Abwesend

Berücksichtigt wird eine neue experimentelle Methode zur Messung der Temperatur erhitzter Objekte unter Verwendung eines kontinuierlichen Spektrums von Wärmestrahlung, das in einem weiten Wellenlängenbereich (z. B. von 200 bis 1000 nm) aufgezeichnet wird. Die Vorteile der Spektralpyrometrie gegenüber herkömmlichen Helligkeits- und Farbmethoden werden diskutiert...

Abwesend

Es werden moderne Begriffe und Konzepte aus dem Bereich der Druckverarbeitung vorgestellt. Das physikalische Wesen der gebräuchlichsten modernen Druckbehandlungsverfahren wird dargelegt, ihre technologischen Möglichkeiten betrachtet und Abhängigkeiten zur Berechnung der wichtigsten technologischen Parameter angegeben. Dargestellt werden Diagramme zu...

Experimentelle Profile von Stoßwellen in kondensierter Materie

Experimentelle Physik - Shutov V.I.., Suchow V.G., Podlesny D.V.. - 2005

Beschrieben wird die experimentelle Arbeit, die im Rahmen eines Physik-Workshops im Programm der Physik- und Mathematik-Lyzeen enthalten ist. Das Handbuch ist ein Versuch, einen einheitlichen Leitfaden für die Durchführung praktischer Unterrichtsstunden in Klassen und Schulen mit vertieftem Physikstudium sowie für die Vorbereitung auf experimentelle Runden hochrangiger Olympiaden zu schaffen.

Das Einführungsmaterial widmet sich traditionell den Methoden zur Verarbeitung experimenteller Daten. Die Beschreibung jeder experimentellen Arbeit beginnt mit einer theoretischen Einführung. Der experimentelle Teil enthält Beschreibungen von Versuchsaufbauten und Aufgabenstellungen, die den Arbeitsablauf der Studierenden bei der Durchführung von Messungen regeln. Es werden Musterarbeitsblätter zur Erfassung von Messergebnissen, Empfehlungen zu Methoden zur Verarbeitung und Darstellung der Ergebnisse sowie Anforderungen an die Berichterstattung bereitgestellt. Am Ende der Beschreibungen werden Testfragen angeboten, auf deren Antworten sich die Studierenden zur Verteidigung ihrer Arbeit vorbereiten müssen.

Für Schulen und Klassen mit vertieftem Physikstudium.

Einführung.

Fehler physikalischer Größen. Verarbeitung von Messergebnissen.

Praktische Arbeit 1. Messung des Volumens von Körpern regelmäßiger Form.

Praktische Arbeit 2. Untersuchung der geradlinigen Bewegung von Körpern im Bereich der Schwerkraft mit einer Atwood-Maschine.

Praktische Arbeit 3. Trockenreibung. Bestimmung des Gleitreibungskoeffizienten.

Theoretische Einführung in die Arbeit an Schwingungen.

Praktische Arbeit 4. Untersuchung der Schwingungen eines Federpendels.

Praktische Arbeit 5. Untersuchung der Schwingungen eines mathematischen Pendels. Bestimmung der Beschleunigung im freien Fall.

Praktische Arbeit 6. Untersuchung der Schwingungen eines physikalischen Pendels.

Praktische Arbeit 7. Bestimmung der Trägheitsmomente von Körpern regelmäßiger Form nach der Methode der Drehschwingungen.

Praktische Arbeit 8. Studium der Rotationsgesetze eines starren Körpers auf einem kreuzförmigen Oberbeck-Pendel.

Praktische Arbeit 9. Bestimmung des Verhältnisses der molaren Wärmekapazitäten von Luft.

Praktische Arbeit 10. Stehende Wellen. Messung der Wellengeschwindigkeit in einer elastischen Schnur.

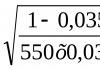

Praktische Arbeit 11. Bestimmung des Verhältnisses ср/с ι? für Luft in einer stehenden Schallwelle.

Praktische Arbeit 12. Untersuchung der Funktionsweise eines elektronischen Oszilloskops.

Praktische Arbeit 13. Messung der Schwingungsfrequenz durch Untersuchung von Lissajous-Figuren.

Praktische Arbeit 14. Bestimmung des spezifischen Widerstands von Nichromdraht.

Praktische Arbeit 15. Bestimmung des Leiterwiderstands mit der Wheatstone-Kompensationsmethode.

Praktische Arbeit 16. Transiente Prozesse in einem Kondensator. Bestimmung der Kapazität.

Praktische Arbeit 17. Bestimmung der elektrischen Feldstärke in einem zylindrischen Leiter mit Strom.

Praktische Arbeit 18. Untersuchung des Betriebs einer Quelle in einem Gleichstromkreis.

Praktische Arbeit 19. Studium der Gesetze der Reflexion und Lichtbrechung.

Praktische Arbeit 20. Bestimmung der Brennweiten von Sammel- und Zerstreuungslinsen.

Praktische Arbeit 21. Das Phänomen der elektromagnetischen Induktion. Untersuchung des Magnetfeldes des Magneten.

Praktische Arbeit 22. Untersuchung gedämpfter Schwingungen.

Praktische Arbeit 23. Untersuchung des Resonanzphänomens in einem Wechselstromkreis.

Praktische Arbeit 24. Fraunhofer-Beugung am Spalt. Messung der Spaltbreite mit der „Wellenmethode“.

Praktische Arbeit 25. Fraunhofer-Beugung. Beugungsgitter als optisches Gerät.

Praktische Arbeit 26. Bestimmung des Brechungsindex von Glas nach der „Wellen“-Methode.

Praktische Arbeit 27. Bestimmung des Krümmungsradius einer Linse im Experiment mit Newtons Ringen.

Praktische Arbeit 28. Untersuchung von polarisiertem Licht.

Laden Sie das E-Book kostenlos in einem praktischen Format herunter, schauen Sie es sich an und lesen Sie:

Laden Sie das Buch Experimental Physics herunter - Shutov V.I., Sukhov V.G., Podlesny D.V. - 2005 - fileskachat.com, schneller und kostenloser Download.

Laden Sie djvu herunter

Sie können dieses Buch unten kaufen Bestpreis mit Rabatt bei Lieferung in ganz Russland.

I. Gegenstand und Struktur der Physik

Physik ist eine Wissenschaft, die die einfachsten und zugleich allgemeinsten Muster natürlicher Phänomene, die Eigenschaften und Struktur der Materie sowie die Gesetze ihrer Bewegung untersucht. Daher liegen der gesamten Naturwissenschaft die Konzepte der Physik und ihrer Gesetze zugrunde. Die Physik gehört zu den exakten Wissenschaften und untersucht die quantitativen Gesetze von Phänomenen.

Das Wort „F.“ kommt aus dem Griechischen. ph?sis – Natur. Im Zeitalter der antiken Kultur wurde die Wissenschaft zunächst nicht zerlegt und umfasste das gesamte Wissen über Naturphänomene. Mit der Differenzierung von Wissen und Forschungsmethoden entstanden aus der allgemeinen Naturwissenschaft, einschließlich der Naturwissenschaften, eigenständige Wissenschaften. Die Grenzen, die die Naturwissenschaften von anderen Naturwissenschaften trennen, sind weitgehend willkürlich und ändern sich im Laufe der Zeit.

Im Kern ist die Philosophie eine experimentelle Wissenschaft: Ihre Gesetze basieren auf experimentell ermittelten Tatsachen. Diese Gesetze stellen quantitative Zusammenhänge dar und sind in mathematischer Sprache formuliert. Man unterscheidet zwischen der experimentellen Physiologie – Experimenten, die durchgeführt werden, um neue Fakten zu entdecken und bekannte physikalische Gesetze zu überprüfen – und der theoretischen Physiologie, deren Zweck es ist, die Naturgesetze zu formulieren und bestimmte Phänomene auch auf der Grundlage dieser Gesetze zu erklären um neue Phänomene vorherzusagen. Bei der Untersuchung eines Phänomens sind Erfahrung und Theorie gleichermaßen notwendig und miteinander verbunden.

Entsprechend der Vielfalt der untersuchten Gegenstände und Bewegungsformen der physikalischen Materie wird die Philosophie in eine Reihe mehr oder weniger miteinander verwandter Disziplinen (Abschnitte) unterteilt. Die Einteilung der Physiologie in einzelne Disziplinen ist nicht eindeutig und kann orientiert erfolgen verschiedene Kriterien. Basierend auf den untersuchten Objekten wird die Physik in die Physik der Elementarteilchen, die Physik der Kerne, die Physik der Atome und Moleküle, die Physik der Gase und Flüssigkeiten, die Physik der Festkörper und die Physik des Plasmas unterteilt. DR. Kriterium - die Prozesse oder Bewegungsformen der untersuchten Materie. Es gibt: mechanische Bewegung, thermische Prozesse, elektromagnetische Phänomene, Gravitation, starke, schwache Wechselwirkungen; Dementsprechend umfasst die Physik die Mechanik materieller Punkte und fester Körper, die Mechanik kontinuierlicher Medien (einschließlich Akustik), die Thermodynamik und statistische Mechanik, die Elektrodynamik (einschließlich Optik), die Theorie der Schwerkraft, die Quantenmechanik und die Quantenfeldtheorie. Die angegebenen Unterteilungen von f. überschneiden sich teilweise aufgrund der tiefen inneren Beziehung zwischen den Objekten der materiellen Welt und den Prozessen, an denen sie beteiligt sind. Je nach Forschungszweck wird manchmal auch zwischen angewandter Optik unterschieden (z. B. Angewandte Optik).

Die Physik legt besonderen Wert auf die Lehre von Schwingungen und Wellen, was auf die gemeinsamen Muster von Schwingungsprozessen verschiedener physikalischer Natur und Methoden zu deren Untersuchung zurückzuführen ist. Es untersucht mechanische, akustische, elektrische und optische Schwingungen und Wellen aus einer einheitlichen Perspektive.

Die moderne Physiologie enthält eine kleine Anzahl grundlegender physikalischer Theorien, die alle Bereiche der Physiologie abdecken. Diese Theorien stellen die Quintessenz des Wissens über die Natur physikalischer Prozesse und Phänomene dar, eine ungefähre, aber vollständigste Widerspiegelung der verschiedenen Bewegungsformen der Materie in der Natur.

II. Hauptstadien in der Entwicklung der Physik

Die Entstehung der Physik (bis zum 17. Jahrhundert). Die physikalischen Phänomene der umgebenden Welt erregen seit langem die Aufmerksamkeit der Menschen. Versuche einer kausalen Erklärung dieser Phänomene gingen der Entstehung der Philosophie im modernen Sinne des Wortes voraus. In der griechisch-römischen Welt (6. Jahrhundert v. Chr. – 2. Jahrhundert n. Chr.) entstanden erstmals Vorstellungen über die atomare Struktur der Materie (Demokrit, Epikur, Lucretius), ein geozentrisches Weltsystem wurde entwickelt (Ptolemaios) und die einfachsten Gesetze Es wurden die etablierte Statik (die Regel der Hebelwirkung), das Gesetz der geradlinigen Ausbreitung und das Gesetz der Lichtreflexion entdeckt, die Prinzipien der Hydrostatik formuliert (Archimedes-Gesetz) und die einfachsten Erscheinungsformen von Elektrizität und Magnetismus beobachtet.

Das Ergebnis erworbener Erkenntnisse im 4. Jahrhundert. Chr e. wurde von Aristoteles enttäuscht. Die Physik des Aristoteles enthielt einige korrekte Bestimmungen, aber gleichzeitig fehlten ihr viele fortschrittliche Ideen ihrer Vorgänger, insbesondere die Atomhypothese. Aristoteles erkannte die Bedeutung der Erfahrung und betrachtete sie nicht als Hauptkriterium für die Verlässlichkeit von Wissen, sondern bevorzugte spekulative Ideen. Im Mittelalter bremsten die von der Kirche heiliggesprochenen Lehren des Aristoteles die Entwicklung der Wissenschaft für lange Zeit.

Die Wissenschaft wurde erst im 15. und 16. Jahrhundert wiederbelebt. im Kampf gegen die scholastischen Lehren des Aristoteles. Mitte des 16. Jahrhunderts. N. Kopernikus stellte ein heliozentrisches Weltsystem vor und markierte den Beginn der Befreiung der Naturwissenschaft von der Theologie. Die Bedürfnisse der Produktion, die Entwicklung des Handwerks, der Schifffahrt und der Artillerie stimulierten die auf Erfahrungen basierende wissenschaftliche Forschung. Allerdings im 15.–16. Jahrhundert. Experimentelle Studien waren größtenteils zufällig. Erst im 17. Jahrhundert. Die systematische Anwendung der experimentellen Methode in der Physik begann und führte zur Entstehung der ersten grundlegenden physikalischen Theorie – Newtons klassischer Mechanik.

Entstehung der Physik als Wissenschaft (Anfang 17. – Ende 18. Jahrhundert)

Die Entwicklung der Physiologie als Wissenschaft im modernen Sinne des Wortes geht auf die Werke von G. Galilei (erste Hälfte des 17. Jahrhunderts) zurück, der die Notwendigkeit einer mathematischen Beschreibung der Bewegung erkannte. Er zeigte, dass der Einfluss umgebender Körper auf einen bestimmten Körper nicht die Geschwindigkeit bestimmt, wie in der aristotelischen Mechanik angenommen wurde, sondern die Beschleunigung des Körpers. Diese Aussage stellte die erste Formulierung des Trägheitsgesetzes dar. Galilei entdeckte das Relativitätsprinzip in der Mechanik (siehe Galileis Relativitätsprinzip), bewies die Unabhängigkeit der Beschleunigung des freien Falls von Körpern von ihrer Dichte und Masse und begründete die kopernikanische Theorie. Auch auf anderen Gebieten der Physik erzielte er bedeutende Ergebnisse: Er baute ein Teleskop mit starker Vergrößerung und machte mit seiner Hilfe eine Reihe astronomischer Entdeckungen (Berge auf dem Mond, Satelliten des Jupiter usw.). Die quantitative Untersuchung thermischer Phänomene begann, nachdem Galilsem das erste Thermometer erfunden hatte.

In der 1. Hälfte des 17. Jahrhunderts. Die erfolgreiche Untersuchung von Gasen begann. Galileis Schüler E. Torricelli stellte die Existenz des Atmosphärendrucks fest und schuf das erste Barometer. R. Boyle und E. Marriott untersuchten die Elastizität von Gasen und formulierten das erste Gasgesetz, das ihren Namen trägt. W. Snell und R. Descartes entdeckten das Gesetz der Lichtbrechung. Gleichzeitig entstand das Mikroskop. Ein bedeutender Fortschritt in der Erforschung magnetischer Phänomene wurde gleich zu Beginn des 17. Jahrhunderts gemacht. W. Gilbert. Er bewies, dass die Erde ein großer Magnet ist, und unterschied als erster streng zwischen elektrischen und magnetischen Phänomenen.

Die wichtigste Errungenschaft von F. 17. Jahrhundert. war die Entstehung der klassischen Mechanik. I. Newton entwickelte die Ideen von Galileo, H. Huygens und anderen Vorgängern weiter und formulierte in seinem Werk „Mathematische Prinzipien der Naturphilosophie“ (1687) alle Grundgesetze dieser Wissenschaft (siehe Newtons Gesetze der Mechanik). Bei der Konstruktion der klassischen Mechanik wurde erstmals das bis heute bestehende Ideal einer wissenschaftlichen Theorie verkörpert. Mit dem Aufkommen der Newtonschen Mechanik wurde schließlich verstanden, dass die Aufgabe der Wissenschaft darin besteht, die allgemeinsten quantitativ formulierten Naturgesetze zu finden.

Den größten Erfolg erzielte die Newtonsche Mechanik bei der Erklärung der Bewegung von Himmelskörpern. Basierend auf den Gesetzen der Planetenbewegung, die von J. Kepler auf der Grundlage von Beobachtungen von T. Brahe aufgestellt wurden, entdeckte Newton das Gesetz der universellen Gravitation (siehe Newtons Gravitationsgesetz). Mit Hilfe dieses Gesetzes war es möglich, die Bewegung des Mondes, der Planeten und Kometen des Sonnensystems mit bemerkenswerter Genauigkeit zu berechnen und die Ebbe und Flut des Ozeans zu erklären. Newton hielt an dem Konzept der Fernwirkung fest, wonach die Wechselwirkung von Körpern (Teilchen) augenblicklich direkt durch den Hohlraum erfolgt; Wechselwirkungskräfte müssen experimentell ermittelt werden. Er war der erste, der die klassischen Konzepte des absoluten Raums als eines von seinen Eigenschaften und seiner Bewegung unabhängigen Behälters der Materie und der absoluten, gleichmäßig fließenden Zeit klar formulierte. Bis zur Entstehung der Relativitätstheorie erfuhren diese Ideen keine Änderungen.

Gleichzeitig formulierten Huygens und G. Leibniz das Gesetz der Impulserhaltung; Huygens entwickelte die Theorie eines physikalischen Pendels und baute eine Uhr mit Pendel.

Die Entwicklung der physikalischen Akustik begann. M. Mersenne maß die Anzahl der Eigenschwingungen einer klingenden Saite und bestimmte erstmals die Schallgeschwindigkeit in Luft. Newton hat theoretisch eine Formel für die Schallgeschwindigkeit abgeleitet.

In der 2. Hälfte des 17. Jahrhunderts. Die geometrische Optik begann sich im Zusammenhang mit der Konstruktion von Teleskopen und anderen optischen Instrumenten rasch zu entwickeln, und die Grundlagen der physikalischen Optik wurden gelegt. F. Grimaldi entdeckte die Lichtbeugung und Newton führte sie aus Grundlagenforschung Lichtstreuung. Die optische Spektroskopie geht auf diese Arbeiten Newtons zurück. Im Jahr 1676 maß O. C. Roemer erstmals die Lichtgeschwindigkeit. Fast gleichzeitig entstanden und begannen sich zwei verschiedene Theorien über die physikalische Natur des Lichts zu entwickeln – Korpuskular und Welle (siehe Optik). Nach Newtons Korpuskulartheorie ist Licht ein Teilchenstrom, der sich von einer Quelle in alle Richtungen bewegt. Huygens legte den Grundstein für die Wellentheorie des Lichts, nach der Licht ein Wellenstrom ist, der sich in einem speziellen hypothetischen Medium – dem Äther – ausbreitet, den gesamten Raum ausfüllt und in alle Körper eindringt.

So im 17. Jahrhundert. Im Wesentlichen wurde die klassische Mechanik aufgebaut und mit der Forschung in anderen Bereichen der Philosophie begonnen: in der Optik, dem Studium elektrischer und magnetischer Phänomene, Wärme und Akustik.

Im 18. Jahrhundert Die Entwicklung der klassischen Mechanik, insbesondere der Himmelsmechanik, wurde fortgesetzt. Basierend auf einer kleinen Anomalie in der Bewegung des Planeten Uranus war es möglich, die Existenz eines neuen Planeten vorherzusagen – Neptun (entdeckt 1846). Das Vertrauen in die Gültigkeit der Newtonschen Mechanik wurde allgemein. Auf der Grundlage der Mechanik wurde ein einheitliches mechanisches Weltbild geschaffen, nach dem der gesamte Reichtum, die gesamte qualitative Vielfalt der Welt das Ergebnis von Unterschieden in der Bewegung der Teilchen (Atome) ist, aus denen Körper bestehen, und der Bewegung, die gehorcht Newtons Gesetze. Dieses Bild hatte über viele Jahre hinweg starken Einfluss auf die Entwicklung der Physik. Eine Erklärung eines physikalischen Phänomens galt als wissenschaftlich und vollständig, wenn sie auf die Wirkung der Gesetze der Mechanik reduziert werden konnte.

Ein wichtiger Impuls für die Entwicklung der Mechanik waren die Anforderungen der sich entwickelnden Produktion. In den Werken von L. Euler und anderen wurde die Dynamik eines absolut starren Körpers entwickelt. Parallel zur Entwicklung der Mechanik von Teilchen und Festkörpern erfolgte eine Entwicklung der Mechanik von Flüssigkeiten und Gasen. Durch die Werke von D. Bernoulli, Euler, J. Lagrange und anderen in der 1. Hälfte des 18. Jahrhunderts. Der Grundstein für die Hydrodynamik einer idealen Flüssigkeit wurde gelegt – einer inkompressiblen Flüssigkeit ohne Viskosität und Wärmeleitfähigkeit. In Lagranges „Analytischer Mechanik“ (1788) werden die Gleichungen der Mechanik in einer so verallgemeinerten Form dargestellt, dass sie anschließend auf nichtmechanische, insbesondere elektromagnetische Prozesse angewendet werden konnten.

In anderen Bereichen der Physiologie wurden experimentelle Daten gesammelt und einfachste experimentelle Gesetze formuliert. S. F. Dufay entdeckte die Existenz zweier Arten von Elektrizität und stellte fest, dass sich gleich geladene Körper abstoßen und entgegengesetzt geladene Körper anziehen. B. Franklin stellte das Gesetz zur Erhaltung der elektrischen Ladung auf. G. Cavendish und unabhängig davon C. Coulomb entdeckten das Grundgesetz der Elektrostatik, das die Wechselwirkungskraft zwischen stationären elektrischen Ladungen bestimmt (Coulombsches Gesetz). Es entstand die Lehre von der atmosphärischen Elektrizität. Franklin, M. V. Lomonosov und G. V. Richman haben die elektrische Natur von Blitzen bewiesen. In der Optik wurde die Verbesserung der Teleskopobjektive fortgesetzt. Durch die Arbeiten von P. Bouguer und I. Lambert begann die Photometrie zu entstehen. Es wurden Infrarot- (W. Herschel, englischer Wissenschaftler W. Wollaston) und ultraviolette (deutscher Wissenschaftler N. Ritter, Wollaston) Strahlen entdeckt.

Bei der Untersuchung thermischer Phänomene wurden bemerkenswerte Fortschritte erzielt; Nach J. Blacks Entdeckung der latenten Fusionswärme und dem experimentellen Nachweis der Wärmeerhaltung begannen kalorimetrische Experimente, zwischen Temperatur und Wärmemenge zu unterscheiden. Das Konzept der Wärmekapazität wurde formuliert und mit der Erforschung der Wärmeleitfähigkeit und Wärmestrahlung begonnen. Gleichzeitig wurden falsche Ansichten über die Natur der Wärme etabliert: Wärme wurde als eine besondere Art unzerstörbarer schwereloser Flüssigkeit betrachtet – kalorisch, die in der Lage ist, von erhitzten Körpern zu kalten zu fließen. Die Wärmetheorie, nach der Wärme eine Art innere Bewegung von Teilchen ist, erlitt eine vorübergehende Niederlage, obwohl sie von so herausragenden Wissenschaftlern wie Newton, Hooke, Boyle, Bernoulli, Lomonosov und anderen unterstützt und weiterentwickelt wurde.

Klassische Physik (19. Jahrhundert)

Zu Beginn des 19. Jahrhunderts. Der langjährige Wettbewerb zwischen der Korpuskular- und der Wellentheorie des Lichts endete mit dem scheinbar endgültigen Sieg der Wellentheorie. Dies wurde durch die erfolgreiche Erklärung des Phänomens der Interferenz und Beugung von Licht mithilfe der Wellentheorie durch T. Jung und O. J. Fresnel erleichtert. Diese Phänomene sind ausschließlich der Wellenbewegung eigen und es schien unmöglich, sie mit der Korpuskulartheorie zu erklären. Gleichzeitig wurde der entscheidende Beweis für die transversale Natur von Lichtwellen erbracht (Fresnel, D. F. Arago, Jung), der bereits im 18. Jahrhundert entdeckt wurde. (Siehe Polarisation von Licht). Fresnel betrachtete Licht als Transversalwellen in einem elastischen Medium (Äther) und fand ein quantitatives Gesetz, das die Intensität gebrochener und reflektierter Lichtwellen beim Übergang von Licht von einem Medium in ein anderes bestimmt (siehe Fresnel-Formeln), und entwickelte außerdem die Theorie der Doppelbrechung .

Sehr wichtig Die Entdeckung des elektrischen Stroms durch L. Galvani und A. Volta trug zur Entwicklung der Physik bei. Die Schaffung leistungsstarker Gleichstromquellen – galvanische Batterien – ermöglichte es, die vielfältigen Auswirkungen von Strom zu erkennen und zu untersuchen. Die chemische Wirkung von Strom wurde untersucht (G. Davy, M. Faraday). V. V. Petrov erhielt einen Lichtbogen. Die Entdeckung der Wirkung von elektrischem Strom auf eine Magnetnadel durch H. K. Oersted (1820) bewies den Zusammenhang zwischen Elektrizität und Magnetismus. Basierend auf der Einheit elektrischer und magnetischer Phänomene kam A. Ampere zu dem Schluss, dass alle magnetischen Phänomene durch die Bewegung geladener Teilchen – elektrischen Strom – verursacht werden. Anschließend stellte Ampere experimentell ein Gesetz auf, das die Wechselwirkungskraft elektrischer Ströme bestimmt (Ampere-Gesetz).

1831 entdeckte Faraday das Phänomen der elektromagnetischen Induktion (siehe Elektromagnetische Induktion). Beim Versuch, dieses Phänomen mit dem Konzept der Fernwirkung zu erklären, stieß man auf erhebliche Schwierigkeiten. Faraday stellte (noch vor der Entdeckung der elektromagnetischen Induktion) eine Hypothese auf, nach der elektromagnetische Wechselwirkungen über einen Zwischenwirkstoff – ein elektromagnetisches Feld – erfolgen (das Konzept der Nahbereichswirkung). Dies markierte den Beginn der Entstehung einer neuen Wissenschaft über die Eigenschaften und Verhaltensgesetze einer besonderen Form der Materie – des elektromagnetischen Feldes.

Zu Beginn des 19. Jahrhunderts. J. Dalton führte in die Wissenschaft (1803) die Idee von Atomen als kleinsten (unteilbaren) Materieteilchen ein – Träger der chemischen Individualität der Elemente.

Bis zum 1. Viertel des 19. Jahrhunderts. Der Grundstein der Festkörperphysik war gelegt. Im gesamten 17.–18. und frühen 19. Jahrhundert. Es kam zu einer Anhäufung von Daten über die makroskopischen Eigenschaften von Festkörpern (Metalle, technische Materialien, Mineralien usw.) und zur Aufstellung empirischer Gesetze des Festkörperverhaltens unter dem Einfluss äußerer Einflüsse (mechanische Kräfte, Erwärmung, elektrische und magnetische Felder, Licht usw.). Die Untersuchung der elastischen Eigenschaften führte zur Entdeckung des Hookeschen Gesetzes (1660), die Untersuchung der elektrischen Leitfähigkeit von Metallen – zur Aufstellung des Ohmschen Gesetzes (1826), der thermischen Eigenschaften – das Gesetz der Wärmekapazitäten von Dulong und Petit (1819). (siehe Dulong- und Petit-Gesetz). Die grundlegenden magnetischen Eigenschaften von Festkörpern wurden entdeckt. Gleichzeitig wurde eine allgemeine Theorie der elastischen Eigenschaften von Festkörpern aufgestellt (L. M. A. Navier, 1819–26, O. L. Cauchy, 1830). Fast alle dieser Ergebnisse sind durch die Interpretation eines Festkörpers als kontinuierliches Medium gekennzeichnet, obwohl ein erheblicher Teil der Wissenschaftler bereits erkannt hat, dass Festkörper, bei denen es sich meist um Kristalle handelt, eine innere mikroskopische Struktur aufweisen.

Die Entdeckung des Energieerhaltungssatzes, der alle Naturphänomene miteinander verknüpft, war für die Physik und die gesamte Naturwissenschaft von größter Bedeutung. Mitte des 19. Jahrhunderts. Die Äquivalenz von Wärmemenge und Arbeit etc. wurde experimentell nachgewiesen. Es wurde festgestellt, dass Wärme keine hypothetische schwerelose Substanz – Kalorien – ist, sondern eine besondere Form von Energie. In den 40er Jahren 19. Jahrhundert Y. R. Mayer, J. Joule und G. Helmholtz entdeckten unabhängig voneinander das Gesetz der Energieerhaltung und -umwandlung. Der Energieerhaltungssatz wurde zum Grundgesetz der Theorie thermischer Phänomene (Thermodynamik) und erhielt den Namen erster Hauptsatz der Thermodynamik.

Noch vor der Entdeckung dieses Gesetzes gelangte S. Carnot in seinem Werk „Reflexionen über die treibende Kraft des Feuers und über Maschinen, die diese Kraft entwickeln können“ (1824) zu Ergebnissen, die als Grundlage für ein weiteres Grundgesetz der Theorie dienten der Wärme – der zweite Hauptsatz der Thermodynamik. Dieses Gesetz wurde in den Werken von R. Clausius (1850) und W. Thomson (1851) formuliert. Es handelt sich um eine Verallgemeinerung experimenteller Daten, die auf die Irreversibilität thermischer Prozesse in der Natur hinweisen und die Richtung des Möglichen bestimmen Energieprozesse. Eine bedeutende Rolle bei der Konstruktion der Thermodynamik spielten die Studien von J. L. Gay-Lussac, auf deren Grundlage B. Clapeyron die Zustandsgleichung eines idealen Gases fand, die später von D. I. Mendeleev verallgemeinert wurde.

Gleichzeitig mit der Entwicklung der Thermodynamik entwickelte sich die molekularkinetische Theorie thermischer Prozesse. Dies ermöglichte die Einbeziehung thermischer Prozesse in das mechanische Weltbild und führte zur Entdeckung einer neuen Art von Gesetzen – statistischer Gesetze, bei denen alle Zusammenhänge zwischen physikalischen Größen probabilistisch sind.

In der ersten Phase der Entwicklung der kinetischen Theorie des einfachsten Mediums – Gas – berechneten Joule, Clausius und andere die Durchschnittswerte verschiedener physikalischer Größen: die Geschwindigkeit der Moleküle, die Anzahl ihrer Kollisionen pro Sekunde, den Mittelwert frei Pfad usw. Es wurde die Abhängigkeit des Gasdrucks von der Anzahl der Moleküle pro Volumeneinheit und der durchschnittlichen kinetischen Energie der Translationsbewegung der Moleküle ermittelt. Dadurch war die Öffnung möglich physikalische Bedeutung Temperatur als Maß für die durchschnittliche kinetische Energie von Molekülen.

Die zweite Stufe in der Entwicklung der molekularkinetischen Theorie begann mit der Arbeit von J. C. Maxwell. Nachdem er 1859 erstmals das Konzept der Wahrscheinlichkeit in die Philosophie eingeführt hatte, fand er das Gesetz der Geschwindigkeitsverteilung von Molekülen (siehe Maxwell-Verteilung). Danach erweiterten sich die Möglichkeiten der molekularkinetischen Theorie enorm und führten in der Folge zur Entstehung der statistischen Mechanik. L. Boltzmann baute eine kinetische Gastheorie auf und lieferte eine statistische Begründung für die Gesetze der Thermodynamik. Das Hauptproblem, das Boltzmann weitgehend lösen konnte, bestand darin, die zeitliche Reversibilität der Bewegung einzelner Moleküle mit der offensichtlichen Irreversibilität makroskopischer Prozesse in Einklang zu bringen. Nach Boltzmann entspricht das thermodynamische Gleichgewicht eines Systems der maximalen Wahrscheinlichkeit eines gegebenen Zustands. Die Irreversibilität von Prozessen ist mit der Tendenz von Systemen zum wahrscheinlichsten Zustand verbunden. Von großer Bedeutung war der von ihm bewiesene Satz über die gleichmäßige Verteilung der mittleren kinetischen Energie über die Freiheitsgrade.

Die klassische statistische Mechanik wurde in den Arbeiten von J. W. Gibbs (1902) vervollständigt, der eine Methode zur Berechnung von Verteilungsfunktionen für jedes System (nicht nur Gase) im thermodynamischen Gleichgewichtszustand entwickelte. Die statistische Mechanik erlangte im 20. Jahrhundert allgemeine Anerkennung. nach der Schaffung durch A. Einstein und M. Smoluchowski (1905–06) auf der Grundlage der molekularkinetischen Theorie der quantitativen Theorie der Brownschen Bewegung, bestätigt in den Experimenten von J. B. Perrin.

In der 2. Hälfte des 19. Jahrhunderts. Der lange Prozess der Untersuchung elektromagnetischer Phänomene wurde von Maxwell abgeschlossen. In seinem Hauptwerk „Eine Abhandlung über Elektrizität und Magnetismus“ (1873) stellte er Gleichungen für das elektromagnetische Feld auf (die seinen Namen tragen), die alle damals bekannten Fakten aus einem Blickwinkel erklärten und Vorhersagen ermöglichten neue Phänomene. Maxwell interpretierte elektromagnetische Induktion als den Prozess der Erzeugung eines elektrischen Wirbelfeldes durch ein magnetisches Wechselfeld. Anschließend sagte er den gegenteiligen Effekt voraus – die Erzeugung eines magnetischen Feldes durch ein elektrisches Wechselfeld (siehe Verschiebungsstrom). Das wichtigste Ergebnis von Maxwells Theorie war die Schlussfolgerung, dass die Ausbreitungsgeschwindigkeit elektromagnetischer Wechselwirkungen endlich ist und der Lichtgeschwindigkeit entspricht. Die experimentelle Entdeckung elektromagnetischer Wellen durch G. R. Hertz (1886–89) bestätigte die Gültigkeit dieser Schlussfolgerung. Aus Maxwells Theorie folgte, dass Licht elektromagnetischer Natur ist. So wurde die Optik zu einem Zweig der Elektrodynamik. Ganz am Ende des 19. Jahrhunderts. P. N. Lebedev entdeckte und maß experimentell den von Maxwells Theorie vorhergesagten Lichtdruck, und A. S. Popov war der erste, der elektromagnetische Wellen für die drahtlose Kommunikation nutzte.

Im 19. Jahrhundert G. Kirchhoff und R. Bunsen legten den Grundstein für die Spektralanalyse (1859). Auch die Entwicklung der Kontinuumsmechanik wurde fortgesetzt. In der Akustik wurde die Theorie der elastischen Schwingungen und Wellen entwickelt (Helmholtz, J. W. Rayleigh usw.). Es entstand eine Technik zur Erzielung niedriger Temperaturen. Alle Gase außer Helium wurden in flüssigem Zustand und zu Beginn des 20. Jahrhunderts gewonnen. H. Kamerlingh-Onnes (1998) verflüssigte Helium.

Bis zum Ende des 19. Jahrhunderts. F. schien den Zeitgenossen fast vollständig zu sein. Es schien, dass alle physikalischen Phänomene auf die Mechanik von Molekülen (oder Atomen) und Äther reduziert werden könnten. Der Äther galt als mechanisches Medium, in dem elektromagnetische Phänomene stattfinden. Einer der größten Physiker des 19. Jahrhunderts. – W. Thomson achtete nur auf zwei unerklärliche Tatsachen: das negative Ergebnis von Michelsons Experiment zur Erfassung der Bewegung der Erde relativ zum Äther und die aus molekularkinetischer Sicht unverständliche Abhängigkeit der Wärmekapazität von Gasen von der Temperatur Theorie. Doch gerade diese Tatsachen waren der erste Hinweis auf die Notwendigkeit einer Revision der Grundgedanken der Philosophie des 19. Jahrhunderts. Um diese und viele andere später entdeckte Tatsachen zu erklären, war es notwendig, die Relativitätstheorie und die Quantenmechanik zu entwickeln.

Relativistische und Quantenphysik. Physik des Atomkerns und der Elementarteilchen (spätes 19.–20. Jahrhundert).

Der Beginn einer neuen Ära in der Physik wurde durch die Entdeckung des Elektrons durch J. Thomson im Jahr 1897 vorbereitet. Es stellte sich heraus, dass Atome nicht elementar, sondern komplexe Systeme sind, die Elektronen umfassen. Eine wichtige Rolle bei dieser Entdeckung spielte die Untersuchung elektrischer Entladungen in Gasen.

Ende des 19. – Anfang des 20. Jahrhunderts. H. Lorentz legte den Grundstein für die elektronische Theorie. Zu Beginn des 20. Jahrhunderts. Es wurde deutlich, dass die Elektrodynamik eine radikale Überarbeitung der Konzepte von Raum und Zeit erfordert, die Newtons klassischer Mechanik zugrunde liegen. 1905 schuf Einstein die private (spezielle) Relativitätstheorie – eine neue Lehre von Raum und Zeit. Diese Theorie wurde historisch durch die Arbeiten von Lorentz und A. Poincaré vorbereitet.

Die Erfahrung hat gezeigt, dass das von Galilei formulierte Relativitätsprinzip, wonach mechanische Phänomene in allen Inertialbezugssystemen identisch ablaufen, auch für elektromagnetische Phänomene gilt. Daher sollten die Maxwell-Gleichungen ihre Form nicht ändern (sie sollten invariant sein), wenn sie von einem Trägheitsbezugssystem zu einem anderen wechseln. Es stellte sich jedoch heraus, dass dies nur dann zutrifft, wenn sich die Koordinaten- und Zeittransformationen während eines solchen Übergangs von den in der Newtonschen Mechanik gültigen galiläischen Transformationen unterscheiden. Lorentz fand diese Transformationen (Lorentz-Transformationen), konnte ihnen aber nicht die richtige Interpretation geben. Dies hat Einstein in seiner Speziellen Relativitätstheorie getan.

Die Entdeckung der partiellen Relativitätstheorie zeigte die Grenzen des mechanischen Weltbildes auf. Versuche, elektromagnetische Prozesse auf mechanische Prozesse in einem hypothetischen Medium – dem Äther – zu reduzieren, erwiesen sich als unhaltbar. Es wurde deutlich, dass das elektromagnetische Feld eine besondere Form der Materie ist, deren Verhalten nicht den Gesetzen der Mechanik gehorcht.

1916 entwickelte Einstein die allgemeine Relativitätstheorie – die physikalische Theorie von Raum, Zeit und Schwerkraft. Diese Theorie markierte eine neue Etappe in der Entwicklung der Schwerkrafttheorie.

An der Wende vom 19. zum 20. Jahrhundert, noch vor der Entstehung der speziellen Relativitätstheorie, wurde der Beginn der größten Revolution auf dem Gebiet der Physik gelegt, die mit der Entstehung und Entwicklung der Quantentheorie verbunden war.

Ende des 19. Jahrhunderts. Es stellte sich heraus, dass die Verteilung der Wärmestrahlungsenergie über das Spektrum, abgeleitet aus dem Gesetz der klassischen statistischen Physik über die gleichmäßige Energieverteilung über Freiheitsgrade, der Erfahrung widerspricht. Daraus folgte die Theorie, dass Materie bei jeder Temperatur elektromagnetische Wellen aussendet, Energie verliert und auf den absoluten Nullpunkt abkühlt, d. h. dass ein thermisches Gleichgewicht zwischen Materie und Strahlung unmöglich ist. Allerdings widersprach die Alltagserfahrung dieser Schlussfolgerung. Die Lösung wurde 1900 von M. Planck gefunden, der zeigte, dass die Ergebnisse der Theorie mit der Erfahrung übereinstimmen, wenn wir im Widerspruch zur klassischen Elektrodynamik davon ausgehen, dass Atome elektromagnetische Energie nicht kontinuierlich, sondern in getrennten Portionen – Quanten – aussenden. Die Energie jedes dieser Quanten ist direkt proportional zur Frequenz, und der Proportionalitätskoeffizient ist das Wirkungsquantum h = 6,6?10-27 erg?sec, das später als Plancksches Wirkungsquantum bezeichnet wurde.

Im Jahr 1905 erweiterte Einstein Plancks Hypothese dahingehend, dass sich der emittierte Teil der elektromagnetischen Energie auch ausbreitet und nur als Ganzes, d. h. verhält sich wie ein Teilchen (später Photon genannt). Basierend auf dieser Hypothese erklärte Einstein die Gesetze des photoelektrischen Effekts, die nicht in den Rahmen der klassischen Elektrodynamik passen.

Damit wurde die Korpuskulartheorie des Lichts auf einem neuen qualitativen Niveau wiederbelebt. Licht verhält sich wie ein Strom aus Teilchen (Körperchen); Gleichzeitig weist es jedoch auch Welleneigenschaften auf, die sich insbesondere in der Beugung und Interferenz von Licht äußern. Folglich sind dem Licht gleichermaßen Wellen- und Korpuskulareigenschaften inhärent, die aus Sicht der klassischen Physik unvereinbar sind (Dualismus des Lichts). Die „Quantisierung“ der Strahlung führte zu dem Schluss, dass sich die Energie intraatomarer Bewegungen ebenfalls nur sprunghaft ändern kann. Diese Schlussfolgerung wurde 1913 von N. Bohr gezogen.

Zu diesem Zeitpunkt entdeckte E. Rutherford (1911) auf der Grundlage von Experimenten zur Streuung von Alphateilchen an Materie den Atomkern und baute ein Planetenmodell des Atoms. In einem Rutherford-Atom bewegen sich Elektronen um den Kern auf die gleiche Weise, wie sich Planeten um die Sonne bewegen. Nach Maxwells Elektrodynamik ist ein solches Atom jedoch instabil: Elektronen, die sich auf kreisförmigen (oder elliptischen) Bahnen bewegen, erfahren eine Beschleunigung und müssen daher kontinuierlich elektromagnetische Wellen aussenden, Energie verlieren und sich schließlich (wie Berechnungen) allmählich dem Kern nähern angezeigt, für eine Zeit von ca. 10-8 Sekunden) darauf fallen. So erwies sich die Stabilität der Atome und ihrer Linienspektren im Rahmen der Gesetze des klassischen F. als unerklärlich. Bohr fand einen Ausweg aus dieser Schwierigkeit. Er postulierte, dass Atome spezielle stationäre Zustände haben, in denen keine Elektronen emittieren. Strahlung entsteht beim Übergang von einem stationären Zustand in einen anderen. Die Diskretion der Atomenergie wurde durch die Experimente von J. Frank und G. Hertz (1913–14) zur Untersuchung von Kollisionen von durch ein elektrisches Feld beschleunigten Elektronen mit Atomen bestätigt. Für das einfachste Atom, das Wasserstoffatom, konstruierte Bohr eine quantitative Theorie des Emissionsspektrums, die mit dem Experiment übereinstimmt.

Im gleichen Zeitraum (Ende des 19. – Anfang des 20. Jahrhunderts) begann sich die Festkörperphysik in ihrem modernen Verständnis als Physik kondensierter Systeme zu bilden, die aus einer großen Anzahl von Teilchen (~ 1022 cm-3) bestehen. Bis 1925 verlief seine Entwicklung in zwei Richtungen: die Physik des Kristallgitters und die Physik der Elektronen in Kristallen, vor allem in Metallen. Anschließend konvergierten diese Richtungen auf der Grundlage der Quantentheorie.

Die Idee eines Kristalls als Ansammlung von Atomen, die im Raum geordnet angeordnet und durch Wechselwirkungskräfte in einer Gleichgewichtslage gehalten werden, durchlief einen langen Entwicklungsweg und entstand schließlich zu Beginn des 20. Jahrhunderts. Die Entwicklung dieses Modells begann mit der Arbeit von Newton (1686) zur Berechnung der Schallgeschwindigkeit in einer Kette elastisch gebundener Teilchen und wurde von anderen Wissenschaftlern fortgesetzt: D. und I. Bernoulli (1727), Cauchy (1830), W . Thomson (1881) usw.

Ende des 19. Jahrhunderts. E. S. Fedorov legte mit seiner Arbeit über die Struktur und Symmetrie von Kristallen den Grundstein für die theoretische Kristallographie; 1890–91 bewies er die Möglichkeit der Existenz von 230 raumsymmetrischen Kristallgruppen – Arten der geordneten Anordnung von Teilchen in einem Kristallgitter (die sogenannten Fedorov-Gruppen). Im Jahr 1912 entdeckten M. Laue und seine Kollegen die Beugung von Röntgenstrahlen an Kristallen und begründeten damit endgültig die Idee eines Kristalls als einer geordneten Atomstruktur. Basierend auf dieser Entdeckung wurde eine Methode zur experimentellen Bestimmung der Anordnung von Atomen in Kristallen und zur Messung interatomarer Abstände entwickelt, die den Beginn der Röntgenstrukturanalyse markierte [U. L. Bragg und W. G. Bragg (1913), G. W. Wolf (1913)]. In denselben Jahren (1907–1914) wurde die dynamische Theorie der Kristallgitter entwickelt, die Quantenkonzepte bereits maßgeblich berücksichtigte. Im Jahr 1907 erklärte Einstein anhand des Modells eines Kristalls als einer Reihe harmonischer Quantenoszillatoren gleicher Frequenz die beobachtete Abnahme der Wärmekapazität von Festkörpern mit abnehmender Temperatur – eine Tatsache, die in scharfem Widerspruch zum Gesetz von Dulong und steht Petit. Eine fortgeschrittenere dynamische Theorie eines Kristallgitters als eine Reihe gekoppelter Quantenoszillatoren unterschiedlicher Frequenz wurde von P. Debye (1912), M. Born und T. Karman (1913) sowie E. Schrödinger (1914) in einer ähnlichen Form konstruiert zum modernen. Seine neue wichtige Phase begann nach der Schaffung der Quantenmechanik.

Die zweite Richtung (Physik der Elektronensysteme in einem Kristall) begann sich unmittelbar nach der Entdeckung des Elektrons als elektronische Theorie von Metallen und anderen Festkörpern zu entwickeln. In dieser Theorie wurden Elektronen im Metall als Füllung betrachtet Kristallgitter ein Gas aus freien Elektronen, ähnlich einem gewöhnlichen verdünnten molekularen Gas, das dem klassischen entspricht. Boltzmann-Statistik. Die elektronische Theorie ermöglichte die Erklärung der Gesetze von Ohm und Wiedemann-Franz (P. Drude), legte den Grundstein für die Theorie der Lichtstreuung in Kristallen usw. Allerdings passen nicht alle Fakten in den Rahmen der klassischen elektronischen Theorie. Somit wurde die Abhängigkeit des spezifischen Widerstands von Metallen von der Temperatur nicht erklärt; es blieb unklar, warum das Elektronengas keinen nennenswerten Beitrag zur Wärmekapazität von Metallen usw. leistet. Ein Ausweg aus den entstandenen Schwierigkeiten wurde erst nach der Konstruktion der Quantenmechanik gefunden.

Die erste von Bohr geschaffene Version der Quantentheorie war in sich widersprüchlich: Bohr nutzte die Gesetze der Newtonschen Mechanik für die Bewegung von Elektronen und erlegte gleichzeitig künstlich Quantenbeschränkungen für die möglichen Bewegungen von Elektronen auf, die der klassischen Theorie fremd waren.

Die zuverlässig etablierte Diskretion der Wirkung und ihr quantitatives Maß – die Plancksche Konstante h – eine universelle Weltkonstante, die die Rolle der natürlichen Skala natürlicher Phänomene spielt, erforderte eine radikale Umstrukturierung sowohl der Gesetze der Mechanik als auch der Gesetze der Elektrodynamik. Klassische Gesetze gelten nur bei der Betrachtung der Bewegung von Objekten mit ausreichend großer Masse, wenn die Wirkungsdimensionen groß im Vergleich zu h sind und die Diskretion der Wirkung vernachlässigt werden kann.

In den 20er Jahren 20. Jahrhundert Es entstand die tiefgreifendste und umfassendste moderne physikalische Theorie – die Quanten- oder Wellenmechanik – eine konsistente, logisch vollständige nichtrelativistische Theorie der Bewegung von Mikroteilchen, die es auch ermöglichte, viele Eigenschaften makroskopischer Körper und die darin auftretenden Phänomene zu erklären ihnen. Die Quantenmechanik basiert auf der Idee der Quantisierung von Planck – Einstein – Bohr und der von L. de Broglie (1924) aufgestellten Hypothese, dass die duale Korpuskularwellennatur nicht nur für elektromagnetische Strahlung (Photonen), sondern auch charakteristisch ist von allen anderen Arten von Materie. Alle Mikroteilchen (Elektronen, Protonen, Atome usw.) haben neben Korpuskular- und Welleneigenschaften: Jedes von ihnen kann einer Welle zugeordnet werden (deren Länge gleich dem Verhältnis der Planckschen Konstante h zum Impuls des Teilchens ist). , und die Frequenz zum Verhältnis der Teilchenenergie zu h ). De-Broglie-Wellen beschreiben freie Teilchen. Im Jahr 1927 wurde erstmals die Beugung von Elektronen beobachtet, die das Vorhandensein ihrer Welleneigenschaften experimentell bestätigte. Später wurde die Beugung auch bei anderen Mikropartikeln, einschließlich Molekülen, beobachtet (siehe Partikelbeugung).

Im Jahr 1926 formulierte Schrödinger die nach ihm benannte Grundgleichung der Quantenmechanik, als er versuchte, diskrete Werte der Atomenergie aus einer Wellengleichung zu erhalten. W. Heisenberg und Born (1925) konstruierten die Quantenmechanik in einer anderen mathematischen Form – der sogenannten. Matrixmechanik.

Im Jahr 1925 entdeckten J. Yu. Uhlenbeck und S. A. Goudsmit auf der Grundlage experimenteller (spektroskopischer) Daten die Existenz eines Eigendrehimpulses eines Elektrons – Spin (und damit des damit verbundenen Eigen-, Spin- und magnetischen Moments) gleich 1/2 . (Der Spinwert wird normalerweise in der Einheit = h/2? ausgedrückt, die wie h Plancksche Konstante genannt wird; in diesen Einheiten ist der Elektronenspin gleich 1/2.) W. Pauli hat die Bewegungsgleichung von niedergeschrieben ein nichtrelativistisches Elektron in einem externen elektromagnetischen Feld unter Berücksichtigung der Wechselwirkung des magnetischen Spinmoments eines Elektrons mit einem Magnetfeld. 1925 formulierte er auch das sogenannte. Ausschlussprinzip, nach dem es in einem Quantenzustand nicht mehr als ein Elektron geben kann (Pauli-Prinzip). Dieses Prinzip spielte eine entscheidende Rolle bei der Konstruktion der Quantentheorie von Systemen aus vielen Teilchen und erklärte insbesondere die Muster der Füllung von Schalen und Schichten mit Elektronen in Mehrelektronenatomen usw. lieferte eine theoretische Grundlage für Mendelejews Periodensystem der Elemente.

Im Jahr 1928 erhielt P. A. M. Dirac eine quantenrelativistische Gleichung der Elektronenbewegung (siehe Dirac-Gleichung), aus der natürlich folgte, dass das Elektron einen Spin hatte. Basierend auf dieser Gleichung sagte Dirac 1931 die Existenz des Positrons (des ersten Antiteilchens) voraus, das 1932 von K. D. Anderson in der kosmischen Strahlung entdeckt wurde. [Antiteilchen anderer Struktureinheiten Substanzen (Proton und Neutron) – Antiproton und Antineutron wurden 1955 bzw. 1956 experimentell entdeckt.]

Parallel zur Entwicklung der Quantenmechanik erfolgte die Entwicklung der Quantenstatistik – der Quantentheorie des Verhaltens physikalischer Systeme (insbesondere makroskopischer Körper), die aus einer großen Anzahl von Mikropartikeln bestehen. Im Jahr 1924 leitete S. Bose durch Anwendung der Prinzipien der Quantenstatistik auf Photonen – Teilchen mit Spin 1 – die Plancksche Formel für die Energieverteilung im Spektrum der Gleichgewichtsstrahlung ab, und Einstein erhielt die Formel für die Energieverteilung für ein ideales Gas von Molekülen (Bose-Einstein-Statistik). Im Jahr 1926 zeigten P. A. M. Dirac und E. Fermi, dass die Menge der Elektronen (und anderer identischer Teilchen mit Spin 1/2), für die das Pauli-Prinzip gilt, einer anderen Statistik gehorcht – der Fermi-Dirac-Statistik. Im Jahr 1940 stellte Pauli den Zusammenhang zwischen Spin und Statistik her.

Die Quantenstatistik spielte eine wichtige Rolle bei der Entwicklung der Physik der kondensierten Materie und vor allem beim Aufbau der Festkörperphysik. In der Quantensprache können thermische Schwingungen von Kristallatomen als eine Ansammlung einer Art „Teilchen“ betrachtet werden, genauer gesagt als Quasiteilchen – Phononen (eingeführt von I. E. Tamm im Jahr 1929). Dieser Ansatz erklärte insbesondere die Abnahme der Wärmekapazität von Metallen (nach dem T3-Gesetz) mit einer Abnahme der Temperatur T im Tieftemperaturbereich und zeigte auch, dass der Grund für den elektrischen Widerstand von Metallen die Streuung von ist Elektronen nicht durch Ionen, sondern hauptsächlich durch Phononen. Später wurden weitere Quasiteilchen eingeführt. Die Quasiteilchenmethode hat sich als sehr effektiv für die Untersuchung der Eigenschaften komplexer makroskopischer Systeme im kondensierten Zustand erwiesen.

1928 nutzte A. Sommerfeld die Fermi-Dirac-Verteilungsfunktion zur Beschreibung von Transportvorgängen in Metallen. Dies löste eine Reihe von Schwierigkeiten der klassischen Theorie und schuf die Grundlage für die Weiterentwicklung der Quantentheorie kinetischer Phänomene (elektrische und thermische Leitfähigkeit, thermoelektrische, galvanomagnetische und andere Effekte) in Festkörpern, insbesondere in Metallen und Halbleitern.

Nach dem Pauli-Prinzip ist die Energie aller freien Elektronen in einem Metall, selbst beim absoluten Nullpunkt, ungleich Null. Im nicht angeregten Zustand sind alle Energieniveaus, beginnend bei Null und endend mit einem maximalen Niveau (Fermi-Niveau), mit Elektronen besetzt. Dieses Bild ermöglichte es Sommerfeld, den geringen Beitrag von Elektronen zur Wärmekapazität von Metallen zu erklären: Beim Erhitzen werden nur Elektronen in der Nähe des Fermi-Niveaus angeregt.

Die Arbeiten von F. Bloch, H. A. Bethe und L. Brillouin (1928–34) entwickelten eine Theorie der Bandenergiestruktur von Kristallen, die eine natürliche Erklärung für die Unterschiede in den elektrischen Eigenschaften von Dielektrika und Metallen lieferte. Der beschriebene Ansatz, Einzelelektronennäherung genannt, wurde weiterentwickelt und vor allem in der Halbleiterphysik weit verbreitet.

1928 zeigten Ya. I. Frenkel und Heisenberg, dass der Ferromagnetismus auf der Quantenaustauschwechselwirkung beruht (die von Heisenberg 1926 am Beispiel des Heliumatoms untersucht wurde); 1932–33 sagten L. Neel und unabhängig davon L. D. Landau den Antiferromagnetismus voraus.

Die Entdeckungen der Supraleitung durch Kamerlingh Onnes (1911) und der Supraflüssigkeit von flüssigem Helium durch P. L. Kapitsa (1938) stimulierten die Entwicklung neuer Methoden in der Quantenstatistik. Phänomenologie. die Theorie der Superfluidität wurde von Landau (1941) aufgestellt; Ein weiterer Schritt war die Phänomenologie, die Theorie der Supraleitung von Landau und V.L. Ginzburg (1950).

In den 50er Jahren In der statistischen Quantentheorie von Vielteilchensystemen wurden neue leistungsstarke Berechnungsmethoden entwickelt. Eine der bemerkenswertesten Errungenschaften war die Schaffung der mikroskopischen Theorie der Supraleitung durch J. Bardeen, L. Cooper und J. Schrieffer (USA). und N. N. Bogolyubov (UdSSR).

Versuche, eine konsistente Quantentheorie der Lichtemission von Atomen zu konstruieren, führten zu einer neuen Stufe in der Entwicklung der Quantentheorie – der Schaffung der Quantenelektrodynamik (Dirac, 1929).

Im 2. Viertel des 20. Jahrhunderts. Eine weitere revolutionäre Transformation der Physik fand statt, verbunden mit der Kenntnis des Aufbaus des Atomkerns und der darin ablaufenden Prozesse sowie mit der Entstehung der Physik der Elementarteilchen. Die oben erwähnte Entdeckung des Atomkerns durch Rutherford wurde durch die Entdeckung der Radioaktivität und radioaktiven Umwandlungen schwerer Atome bereits im späten 19. Jahrhundert vorbereitet. (A. Becquerel, P. und M. Curie). Zu Beginn des 20. Jahrhunderts. Isotope wurden entdeckt. Die ersten Versuche, die Struktur des Atomkerns direkt zu untersuchen, gehen auf das Jahr 1919 zurück, als Rutherford durch den Beschuss stabiler Stickstoffkerne mit ?-Partikeln deren künstliche Umwandlung in Sauerstoffkerne erreichte. Die Entdeckung des Neutrons im Jahr 1932 durch J. Chadwick führte zur Entwicklung des modernen Proton-Neutron-Modells des Kerns (D. D. Ivanenko, Heisenberg). 1934 entdeckten die Ehegatten I. und F. Joliot-Curie die künstliche Radioaktivität.

Die Entwicklung von Beschleunigern für geladene Teilchen ermöglichte die Untersuchung verschiedener Kernreaktionen. Das wichtigste Ergebnis dieser Phase der Physik war die Entdeckung der Spaltung des Atomkerns.

In den Jahren 1939–45 wurde erstmals Kernenergie mithilfe der 235U-Spaltungskettenreaktion freigesetzt und die Atombombe geschaffen. Das Verdienst, die kontrollierte Kernspaltungsreaktion von 235U für friedliche, industrielle Zwecke zu nutzen, gebührt der UdSSR. 1954 wurde in der UdSSR (Obninsk) das erste Kernkraftwerk gebaut. Später wurden in vielen Ländern kostengünstige Kernkraftwerke errichtet.

1952 wurde eine thermonukleare Fusionsreaktion durchgeführt (eine Atombombe wurde explodiert) und 1953 wurde eine Wasserstoffbombe hergestellt.

Gleichzeitig mit der Physik des Atomkerns im 20. Jahrhundert. Die Physik der Elementarteilchen begann sich rasant zu entwickeln. Erste großer Erfolg in diesem Bereich sind mit der Erforschung der kosmischen Strahlung verbunden. Myonen, Pi-Mesonen, K-Mesonen und die ersten Hyperonen wurden entdeckt. Nach der Entwicklung hochenergetischer Beschleuniger für geladene Teilchen begann eine systematische Untersuchung der Elementarteilchen, ihrer Eigenschaften und Wechselwirkungen; Die Existenz von zwei Arten von Neutrinos wurde experimentell nachgewiesen und viele neue Elementarteilchen entdeckt, darunter extrem instabile Teilchen – Resonanzen, deren durchschnittliche Lebensdauer nur 10-22–10-24 Sekunden beträgt. Die entdeckte universelle Interkonvertibilität von Elementarteilchen deutete darauf hin, dass diese Teilchen nicht im absoluten Sinne elementar sind, sondern eine komplexe innere Struktur haben, die noch entdeckt werden muss. Die Theorie der Elementarteilchen und ihrer Wechselwirkungen (starke, elektromagnetische und schwache) ist Gegenstand der Quantenfeldtheorie – eine Theorie, die noch lange nicht abgeschlossen ist.

III. Grundlegende Theorien der Physik

Klassische Newtonsche Mechanik

Newtons Einführung des Staatsbegriffs war für die gesamte Philosophie von grundlegender Bedeutung. Ursprünglich wurde es für das einfachste mechanische System formuliert – ein System materieller Punkte. Newtons Gesetze gelten direkt für materielle Punkte. In allen nachfolgenden physikalischen Theorien war der Zustandsbegriff einer der Haupttheorien. Der Zustand eines mechanischen Systems wird vollständig durch die Koordinaten und Impulse aller Körper bestimmt, aus denen das System besteht. Wenn die Wechselwirkungskräfte von Körpern bekannt sind, die ihre Beschleunigungen bestimmen, ermöglichen die Bewegungsgleichungen der Newtonschen Mechanik (Newtons zweites Gesetz) aus den Werten von Koordinaten und Impulsen im Anfangszeitpunkt eine eindeutige Feststellung der Werte von Koordinaten und Impulsen zu jedem späteren Zeitpunkt. Koordinaten und Impulse sind die Grundgrößen der klassischen Mechanik; Wenn man sie kennt, kann man den Wert jeder anderen mechanischen Größe berechnen: Energie, Drehimpuls usw. Obwohl später klar wurde, dass die Newtonsche Mechanik einen begrenzten Anwendungsbereich hat, war und bleibt sie die Grundlage, ohne die die Konstruktion der Das gesamte Gebäude der modernen Physiologie wäre unmöglich gewesen.

Kontinuumsmechanik